上修今年AI伺服器出货量 研调:企业、云端服务商高度需求持续

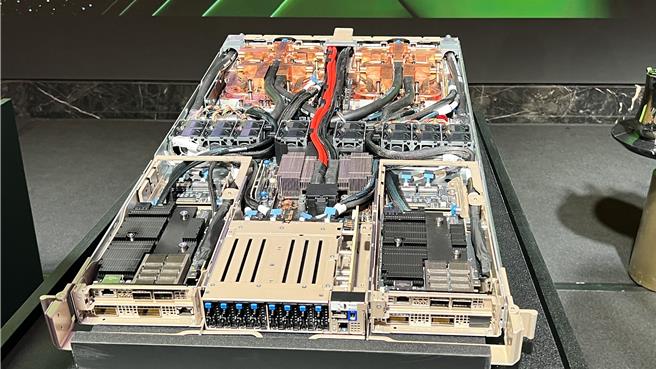

研调机构TrendForce指出,AI伺服器的需求持续,在先进封装、HBM产能扩张后,今年AI伺服器出货量将进一步成长,图为辉达GB200液冷伺服器。(图/柳名耕摄)

研调机构TrendForce 17日发布「AI Server(伺服器)产业分析报告」指出,今年大型的云端服务商以及品牌客户,对于高阶AI伺服器的高度需求未歇,加上台积电CoWoS先进封装及HBM持续扩产下,全年出货量上修至167万台,年增率达41.5%。

TrendForce表示,AI伺服器相关产能扩张后,今年第2季后短缺状况大幅缓解,连带使得NVIDIA主力方案H100的交货前置时间从先前动辄40-50周下降至不到16周,因此预估AI伺服器在第2季出货量将季增近20%,全年出货量上修至167万台,年增率达41.5%。

同时,今年大型云端服务商的预算持续聚焦于采购AI 伺服器,排挤一般伺服器的成长力道,相较于前者的高成长率,后者出货量年增率仅有1.9%;而AI 伺服器占整体伺服器出货的比重预估将达12.2%,较2023年提升约3.4个百分点。若估算产值,AI 伺服器的营收成长贡献程度较一般型伺服器明显,预估2024年AI Server产值将达逾1870亿美元,成长率达69%,产值占整体伺服器市场达65%。

TrendForce指出,展望2025年市场对于高阶AI Server需求仍强,尤其以NVIDIA新一代Blackwell(包含GB200、B100/B200等)将取代Hopper平台成为市场主流,此亦将带动CoWoS及HBM等需求。

以NVIDIA的B100而言,其晶片尺寸将较H100翻倍,会消耗更多的CoWoS用量,预估2025年主要供应商TSMC的CoWoS生产量规模至年底总产能可达550k-600k,成长率逼近8成。